Apple-Nutzer:innen wähnten ihre Daten auf iPhones bislang sicher. Die vermeintlich datenschutzfreundlichen Policies Apples sind für viele Menschen der Grund, warum sie für ein iPhone vierstellige Kaufpreise bezahlen. Doch mit der Einführung des "CSAM-Scannings" tritt Apple die Tür zur Überwachung lokal gespeicherter Dateien auf und schafft einen höchst bedenklichen Präzedenzfall.

"CSAM" steht für "Child Sexual Abuse Material", zu Deutsch also: kinderpornografisches Material. Die meisten Cloud-Anbieter, darunter auch Apple, scannen die Inhalte der Clouds ihrer Nutzer:innen bereits jetzt auf potentiell illegale Inhalte, primär CSAM. Apple setzt dieser Praxis nun die Krone auf.

In einem kürzlich erschienenen White Paper erklärt Apple, wie man – zunächst nur in den USA – noch effektiver gegen die Verbreitung von Kinderpornografie vorgehen möchte: Indem man Dateien bereits vor dem Upload in die iCloud, sprich on-device, also auf dem Gerät, scannt. Apple bastelt sich seinen ganz eigenen Uploadfilter.

Hashes? Kann man das rauchen?

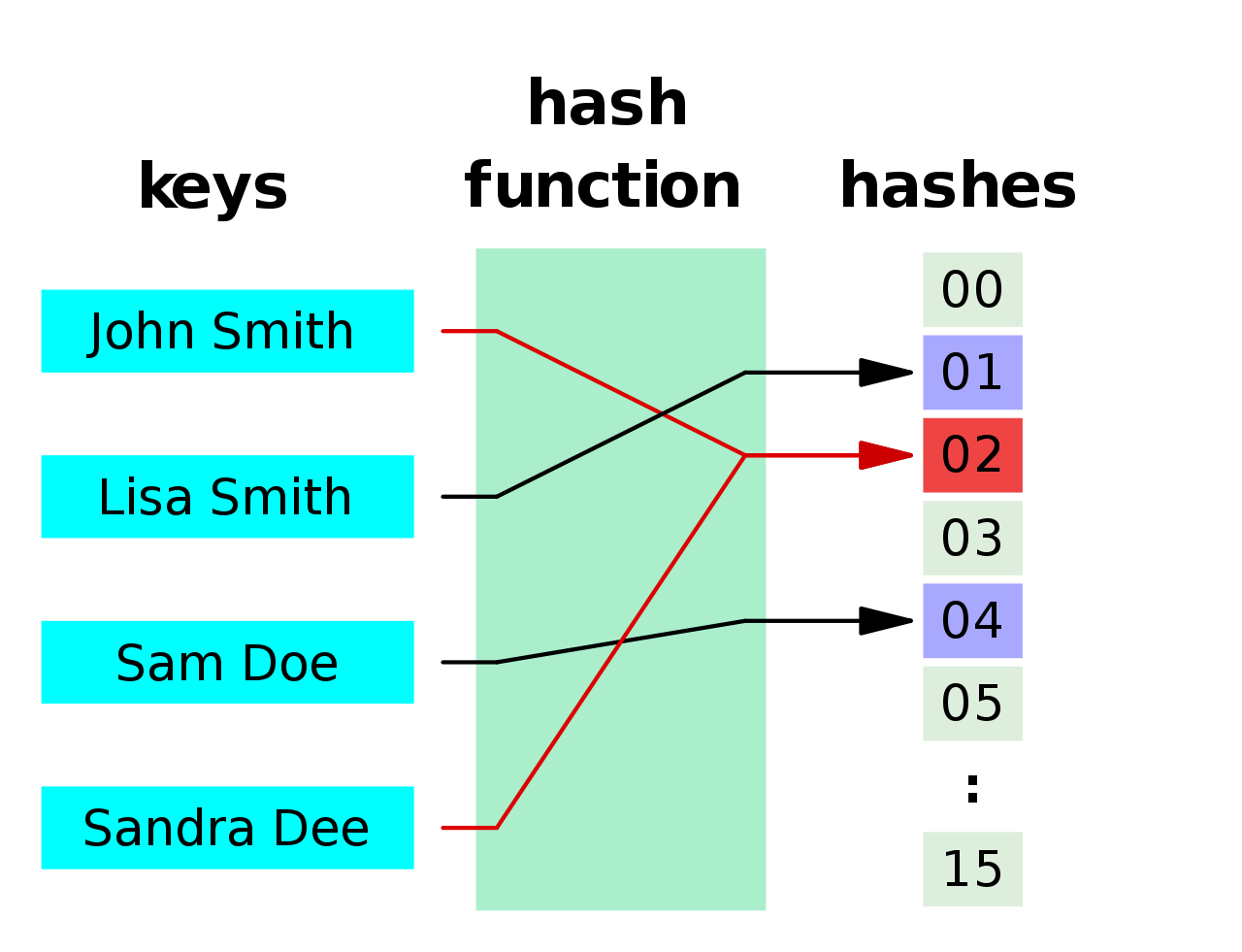

Apple will zur Erkennung kinderpornografischen Materials auf den Endgeräten der Nutzer:innen einen neuartigen "Hash-Algorithmus" einsetzen, genannt "NeuralHash". Ganz allgemein gesagt übersetzen Hash-Algorithmen Informationen wie Namen, Adressen oder Bilddateien in Zahlenfolgen, welche dem Quellmaterial im Nachhinein zugeordnet werden können (sofern der Hash-Algorithmus nicht kryptografisch ist).

Hierbei greift Apple auf eine Hash-Datenbank der US-amerikanischen Non-Profit-Organisation National Center for Missing and Exploited Children (NCMEC) zurück, in der bekanntes kinderpornografisches Bildmaterial gelistet ist. Apple zufolge soll NeuralHash so fortgeschritten sein, dass selbst bei veränderten (zum Beispiel zugeschnittenen) Bildern aus dieser Datenbank der gleiche Hash wie beim Original gebildet wird.

Wenn eine Nutzer:in in den USA künftig ein Foto in die iCloud hochladen möchte, läuft vor dem Upload Apples NeuralHash-Algorithmus über dieses Bild, übersetzt es in einen Hash und gleicht diesen mit der genannten Datenbank des NCMEC ab. Stimmt der Hash des Uploads mit einem Hash aus dieser Datenbank überein, landet der Algorithmus einen "Treffer" und lädt das vermeintlich illegale Material dann zusamen mit einem "Safety Voucher", einer Art verschlüsseltem Warnhinweis, hoch. Apple zufolge reicht ein einzelner Treffer allerdings noch nicht aus, erst ab Erreichen eines "Grenzwerts bekannten CSAM-Materials" will Apple die Vouchers entschlüsseln und an die Strafverfolgungsbehörden weiterleiten. Diese Weitergabe soll durch einen Menschen autorisiert werden müssen und nicht rein algorithmisch erfolgen.

Wie genau der Grenzwert aber zustande kommen soll, darüber schweigt sich der angebissene Apfel aus. Im White Paper ist die Rede von einem Grenzwert von 30 Treffern, doch eben auch davon, dass "wir den Grenzwert unter Umständen verändern werden".

Damm = gebrochen

Jahrelang hieß es von Seiten der großen Tech-Unternehmen, Endgeräte lokal auf illegales Material zu scannen sei technisch unduchführbar. Es sei nun dahingestellt, ob diese Aussage faktisch korrekt oder nur ein Feigenblatt der Marketingabteilungen war, denn sie hat sich erledigt. Apple hat bewiesen, dass es möglich ist. Und dieser Beweis hat Auswirkungen, die kaum zu überschätzen sind.

Solange nämlich die Tech-Unternehmen darauf beharrten, On-Device-Scanning sei nicht machbar, erfüllten sie eine Gatekeeping-Funktion für die Privatsphäre ihrer Nutzer:innen. Selbst die technologisierteste aller Autokratien, mit einem sitzenden Heer von zehntausenden Cyber-Soldat:innen, wird sich die Zähne an US-amerikanischen Firmen ausbeißen, wenn diese nonchalant auf Undurchführbarkeit der gewünschten Überwachungsmaßnahmen plädieren.

Eben hier liegt die Privatsphäre begraben: "technisch nicht möglich" ist kein Argument mehr. Wenn künftig also die Regierungen dieser Welt ihre Überwachungsbefugnisse erweitert sehen wollen, kann Apple diesen Wunsch allenfalls noch aus ethischen Gründen abzuwehren versuchen. Und das wird nicht funktionieren.

Es gibt keine idiotensicheren (Hash-)Algorithmen

Kommen wir noch einmal zurück zu den Hashes. Wie in der obigen Grafik deutlich wird, ist nicht per se sichergestellt, dass jeder Eingabe ein inidividueller Hash zugewiesen wird. Ein Bild mit einem bestimmten Hash kann also durchaus eines der bekannten CSAM-Materialien aus der Hash-Datenbank des NCMEC sein – muss aber eben nicht. Bereits nach wenigen Tagen haben versierte Techies die ersten potentiellen Kollisionen in Apples Algorithmus konstruiert.

Die Hash-Datenbank der NCMEC, das Rückgrat von Apples gesamter Strategie, ist ebenfalls ein potenzielles Risiko. Sollten diese Hashes jemals öffentlich werden, so wäre es möglich, den kompletten Algorithmus nachzubauen und, wie bereits erfolgreich geschehen, Bilder zu generieren, die einen Hashwert ergeben, welcher auf der schwarzen Liste steht. Die so forcierten Kollisionen könnten als Instrument zur Gängelung politischer Gegner:innen oder unliebsamer Personen eingesetzt werden, um Repressionen gegen diese zu rechtfertigen oder ihren Ruf zu schädigen.

Auch die Datenbanken selbst sind anfällig für Manipulation. Es ist nicht auszuschließen, dass staatliche oder private Akteure versuchen werden, unliebsame Inhalte, die vorne und hinten nichts mit Kinderpornografie zu tun haben, in die Datenbanken einzuschleusen. Apple hat bereits angekündigt, dass der Hash eines gescannten Bildes in mindestens zwei Datenbanken auftauchen muss, um geflagged, also per digitaler Signatur als potentiell illegal oder gefährlich markiert zu werden. Außerdem sollen die Hashes in diesen Datenbanken von unabhängigen Stellen geprüft werden.

if (iOS15 == true) {delete iCloud}1

Doch diese Zugeständnisse sind ein schwacher Trost, führt mensch sich vor Augen, dass jedes iPhone in Zukunft mit einer "Wanze ab Werk" ausgeliefert wird. Selbst wenn Apples Algorithmus der beste der Welt, ja sogar der beste aller möglichen Welten ist, am Ende ist es immer noch ein diffuser Haufen Computercode ohne Kognition und Lebenserfahrung, dessen Entscheidungsfindung – wenn überhaupt – diejenigen nachvollziehen können, die ihn programmiert haben. Das Ergebnis sind Nutzer:innen, die in der konstanten Angst leben müssen, dass der Algorithmus "denkt", sie hätten etwas Kriminelles auf ihrem Telefon gespeichert.

Noch beschränkt sich diese Praxis auf die USA, es ist unklar, ob sie überhaupt mit europäischem Recht vereinbar wäre. Angesichts des Kreuzzugs gegen digitale Privatsphäre allerdings, den sich die EU seit einiger Zeit auf die sternbewehrte Flagge geschrieben hat, sollten geneigte Apple-Nutzer:innen wachsam bleiben. Und sich präventiv schon mal mit einem Abschied von der iCloud anfreunden.

1Übersetzung des Javascripts: "wenn du ein Apple-Gerät hast, lösch die iCloud"

In Teil 1 der Serie "Deus Ex Algorithmo" ging es um die Grundfunktionsweisen Sozialer Medien und ihrer Algorithmen, Teil 2 behandelte, wie und warum in den Sozialen Netzwerken Radikalisierung und Desinformation stattfinden; Teil 3 widmete sich möglichen Auswegen aus dem Dilemma. Teil 4 zeigte auf, mit welchen Methoden wir alle durch digitale Werkzeuge und Plattformen überwacht werden und Teil 5 offenbarte, wie Algorithmen rassistische und sexistische Überzeugungen reproduzieren.

2 Kommentare

Kommentare

Petra Pausch am Permanenter Link

Ohne iCloud wird Apple völlig unattraktiv für den Nutzer. Ist es doch gerade die Verfügbarkeit auf allen Apple-Geräten und deren (bisherige) Sicherheit und Verschlüsselung, die den Aufpreis gerechtfertigen.

Rene Goeckel( am Permanenter Link

Die Ähnlichkeit zwischen Apple und Religion wurde ja schon festgestellt. Anders lässt sich die Markentreue und Hörigkeit der User auch nicht erklären. Die Kirchen müssten vor Neid erblassen.